联系我们

关注我们

立即提交

2024年,AI走入推理时代,算力需求发生了显著变化。随着开源模型性能接近GPT-4水平,中小模型应用日益成熟,中小企业和开发者纷纷加入市场。

推理链的出现更是推动了推理市场,其规模预计将迎来千万乃至十亿倍的增长。这一潜在增长趋势导致市场推理需求大幅增加,而训练需求的增长则开始放缓。

与训练阶段相比,推理阶段对硬件要求相对较低。在实际应用中,通常使用最先进的设备进行训练,而上一代产品则用于推理。因此,中小企业/开发者不再盲目追求高端设备,转而关注更具性价比的选择。

01 戳破算力市场的「泡沫」

尽管企业对AI的投入持谨慎态度,但在许多场景下,消费级RTX4090显卡已能很好地满足大模型非预训练的需求,这导致8卡GPU服务器的采购需求量激增,市场出现供不应求的情况。

然而,GPU虽是最昂贵的单个组件,但在每个服务器中的每个GPU的价格范围是准确的,而整个成本结构中,还有其他成本因素需要考虑。

用户若缺乏对市场行情和产品的深入了解,踏入“成本陷阱”,容易在非算力组件被”榨取价值”,做出错误决策,导致成本负担激增。

我们从用户角度汇总

几个遇到的核心问题展开看看:

非算力组件过度投资

PCIE 5.0平台不匹配

算力市场饱和式竞争

源于以上各方面的原因,导致用户投资在非算力部件上,没办法在短时间内形成具体业务形态,严重损害用户利益。

为了解答为什么8卡风扇卡服务器特别适配算力投资,我们有必要捋清下4090显卡应用的真正场景。

02 AI推理:RTX4090真正用途

NVIDIA的GPU产品线广泛覆盖了从消费级到数据中心级的不同市场,其中H100、A100和RTX 4090是各自类别中的佼佼者。

三款GPU各具特色,H100和A100在深度学习训练领域表现卓越;而RTX4090在推理任务中,以其FP16算力性能和亲民价格,在推理应用方面极具性价比。

RTX4090显卡真正的用武之地在于AI推理工作负载——其对AI芯片的显存容量、数据传输带宽以及多卡之间的协同工作能力的要求相对较低。

在AI推理场景中,8卡RTX4090风扇卡服务器就成为了用户在权衡价格、成本及易用性后所青睐的“平衡点”方案。

在考虑将RTX4090显卡集成到风扇卡服务器中用于推理任务时,我们需要知道,RTX4090设计采用PCIE4.0 x16接口,GPU与CPU通信依然是基于PCIe链路互联。

面对成本效益与性能之间的权衡,一个关键问题摆在我们面前——在算力需求相同的情况下,我们应该选择PCIE4.0平台还是PCIE5.0平台?

这是一个需要深思熟虑的决策。

目前市场中出现的使用PCIE5.0平台搭配RTX4090计算卡方案,无疑是基于要实现CPU-GPU直通架构适配而不得已为之的对策。

然而RTX4090显卡基于PCIE4.0接口设计,与PCIE4.0平台有着更好协议匹配,采用PCIE4.0平台可以保证数据传输过程中的一致性,也无需担心其兼容性。

简单粗暴将PCIE4.0平台升级到PCIE5.0平台这种升级也并非是简单的架构替换。升级则需要配套更高性能的硬件设备和相应的技术支持,实际可用带宽并不会因升级而增加,且升级后的性能提升可能有限。

若在PCIE5.0平台使用RTX4090显卡,意味着需要额外投资昂贵的非算力配件,在成本效益上缺乏性价比。

那,还有办法进一步降低吗?

经估算,仅是CPU和DARM两个部件上的成本,PCIE5.0平台比PCIE4.0平台高出 70%。

基于此,选择PCIE4.0平台搭配PCIE4.0 RTX4090无疑就是推理算力最优解。

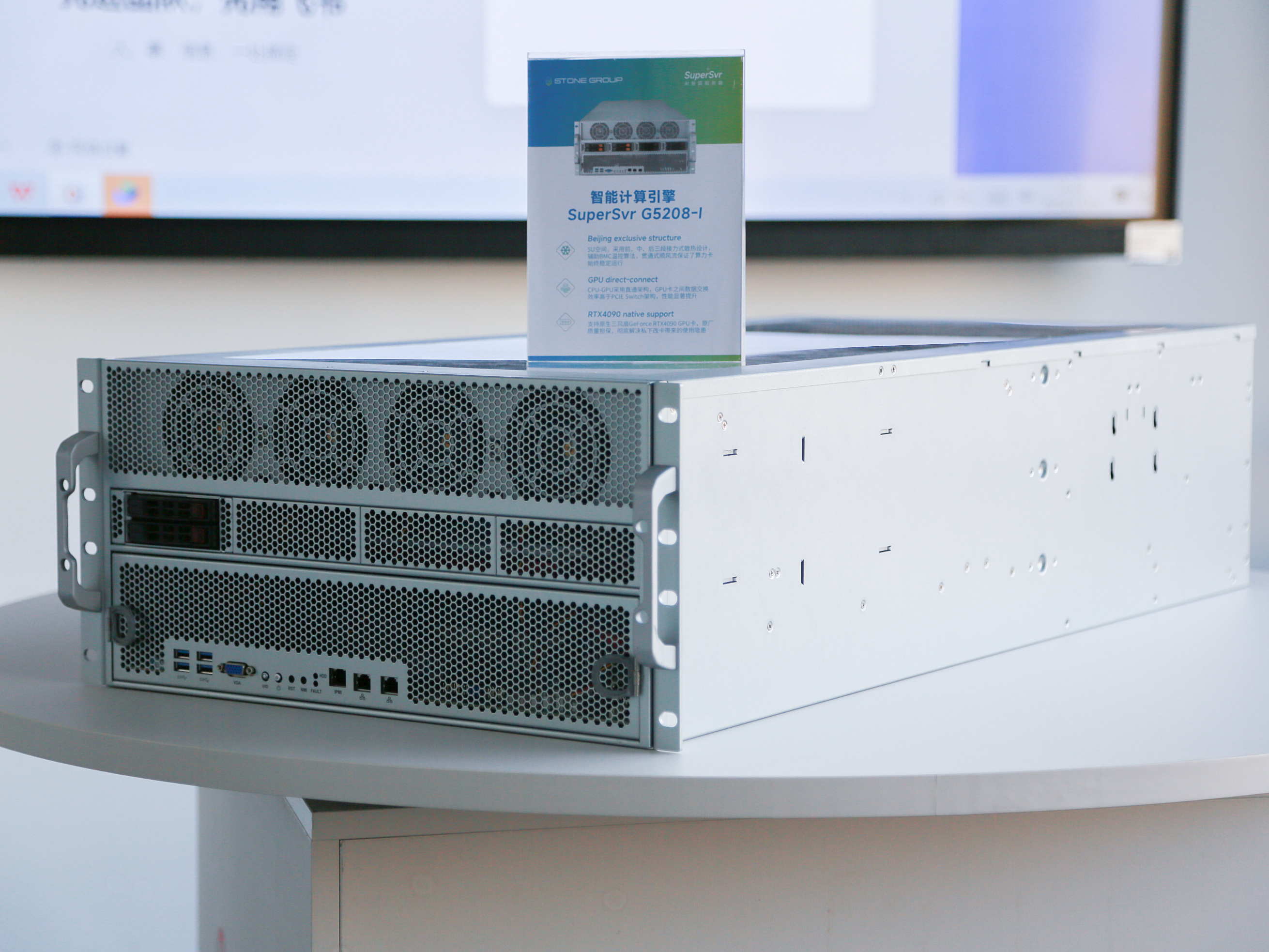

高端品牌和型号,往往因为其出色品质和创新设计,而拥有更广的市场接受度,G5208服务器凭借其出色的性能和架构,则正好迎合了更多用户的算力投资需求。

目前市场上的方案多是基于PCIE4.0平台搭配RTX4090显卡,这表明PCIE4.0平台已经得到了广泛的认可和应用。

PCIE5.0平台的普及尚需时日,而G5208正是基于PCIE4.0技术平台构建,采用CPU-GPU直通架构,在协议匹配性方面更利于RTX4090性能充分发挥。

GPU卡之间数据交换效率高于CPU与GPU卡直通设计,两者数据交互无需通过PCIE Switch通信,提高数据交互效率。以直通架构为基础,G5208服务器实现了性能与成本的卓越平衡,满足多样化场景的实际需求,成为众多业务场景的理想选择。G5208通过合理匹配成本与性能,有效规避成本陷阱,展现了其对技术创新与市场趋势互动的深刻理解,也是对如何让算力投资“务实”的直接回应。

特别是在推理任务和成本敏感的应用领域,原生8卡RTX4090风扇卡G5208服务器已成为服务器租赁提供商和AI研究人员的首选,亦是性价比的最优解!